2023 年6月19日,哈工大讯飞联合实验室(HFL)与认知智能全国重点实验室、河北省讯飞人工智能研究院联合团队在离散推理阅读理解任务DROP取得双指标第一的成绩,获得冠军。DROP评测 (A Reading Comprehension Benchmark Requiring Discrete Reasoning Over Paragraphs )由AI2(艾伦人工智能研究院)举办,旨在全面考察模型的阅读理解和数学推理能力。DROP评测自2019年举办以来吸引了众多知名研究机构和企业参加,其中包括蚂蚁、平安、京东、WeChat AI、Google Research等团队。

DROP 评测:数学推理挑战大,难度高挑战大

DROP 评测任务的形式是让机器理解一个篇章,并回答篇章中的问题,但与其他大多数阅读理解评测任务不同,DROP主要考察模型的数学推理能力。

DROP 任务中的问题主要包括三种类型:数学问题(number)、日期问题(date)以及文本片段(span)问题;并从以下两个指标对机器进行评测:

EM :预测答案与数据标注答案完全一致

F1 :预测答案与标注答案的部分匹配

虽然看上去是简单的加减法,但机器想要做对却并不容易:首先,模型需要理解问题中“青少年人口”和“20到29岁间的成年人口”之间的比较关系,再通过两者的概率值计算得到答案。DROP评测的难点也因此可见一斑:

首先需要根据问题,找到与问题相关的实体、实体之间的关系以及对应的数量或大小等数值,即需要准确定位实体和数值;其次,需要较强的逻辑推理,如样例中比较大小的逻辑,还包含计算时间先后差、统计某个实体数量以及实体数量差/和等等;最后,在准确定位实体和数值并推理出相关的计算逻辑后,模型还需要准确地将对应逻辑计算表达式映射到对应数值,才能最终计算出答案。

目前,即使是GPT-4在DROP上的F1指标也只有80.9%(根据OpenAI官方技术报告中数字),距离人类水平的96.4%还有很大差距,可见DROP任务挑战性之大。

夺冠系统D-Reasoner:面向数学推理,思维链生成是亮点

此次认知智能全国重点实验室实现双指标夺冠的秘诀,在于团队自主研发的D-Reasoner模型,属于Reasoner系列模型。

Reasoner 系列模型是专门用于处理推理型阅读理解任务的系列模型。其中,X-Reasoner模型在2022年的常识推理阅读理解评测OpenBookQA和QASC上分别夺得冠军,并突破了人类最好水平;随后针对逻辑推理的Rational Reasoner模型能力“进阶”,同年获得逻辑推理阅读理解挑战赛ReClor冠军。

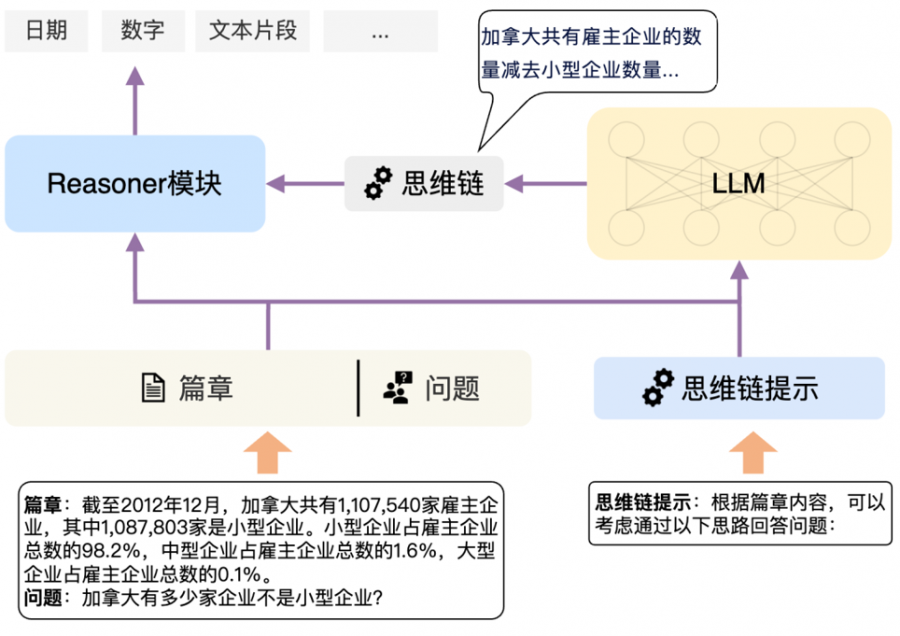

今年,Reasoner系列模型再度升级,研发了针对数学推理的D-Reasoner模型。D-Reasoner主要有两大亮点:利用大语言模型(LLM)对问题以及篇章进行思维链生成,以及结合生成的思维链以及篇章和问题,计算出最终的数值、日期以及文本片段答案。

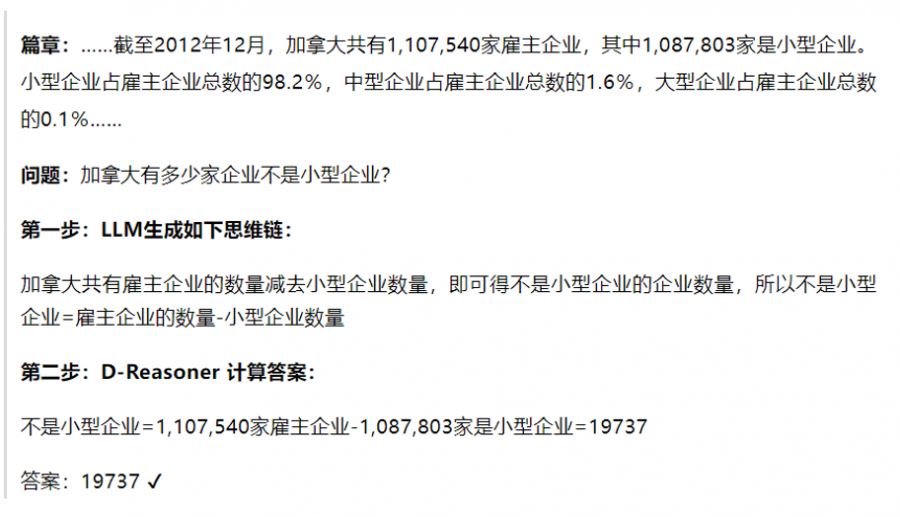

例如通过以下这个评测题目,我们可以看到D-Reasoner模型是如何正确解题的:

D-Reasoner系统流程

D-Reasoner 模型利用大语言模型生成丰富的思维链,这些思维链涵盖了各种数学概念、定理和解题技巧,为专业模型提供了强大的支持。这些思维链应用到专业模型中,使其能够更全面地理解数学问题,更好应对DROP评测中的各种挑战,最终也在DROP评测中脱颖而出、拿下双指标第一。

大模型与专业模型“协同并进”应用大有可为

D-Reasoner 模型系统结合了大模型的能力,从而提升了在数学推理任务上的效果。这意味着拥有优秀泛化能力的大模型不仅可以独立地完成各种通用任务,还可以通过与专业模型结合,在专业领域与任务上发挥重要作用。

此前,认知智能国家重点实验室已多次在国际机器阅读理解评测赛事中取得优异成绩。Reasoner系列模型“队伍”的壮大与成绩,也是科大讯飞在认知智能与大模型相关技术上不断创新突破的表现。未来,讯飞将继续瞄准让“机器能理解会思考”的目标持续攀登,积极推动核心源头技术的进步与应用落地实践。